AI浪潮下,存储芯片高歌猛进

就在本周,全球存储芯片巨头 SK 海力士宣布了最新一轮超过 1000 亿元人民币的投资,计划用于扩大包括 HBM(高带宽内存)在内的下一代 DRAM 的产能。

一点也不意外。

过去一年半,从 ChatGPT 到 Sora 一次又一次刷新了人们对于人工智能的认知。而且从目前来看,Claude 3 的震撼发布,GPT-5 流出的信息,似乎说明大语言模型(以下简称「大模型」)的智力涌现没有丝毫放缓的迹象。

这让 GPU「采购战争」变得愈演愈烈,连带着台积电的 CoWos 以及 HBM 产能也成为了绝对意义的「抢手货」。但大模型在「争夺」的其实不只是 HBM。

随着手机、PC 等计算终端开始积极引入大模型,甚至出现了一系列基于大模型打造的 AI 原生终端,消费电子产品对于 DRAM(内存)、NAND(闪存)的需求也在变多、变大。

从 GPT-3.5 到 Llama 3,大模型要继续带飞存储芯片

当地时间 4 月 18 日,Meta 发布了最新的开源大模型 Llama 3,再次夺回了开源大模型的「王座」。但值得注意的是,Llama 3 的强大很大程度上离不开 15 万亿 Token 的训练数据,这不仅是小公司难以企及的规模,甚至比谷歌之前开源的 Gemma 大模型:

还多出一倍不止。

图/ Meta

从 GPT-3.5 到 Llama 3,时至今日,大模型的智力涌现依然依托于 Scaling laws(OpenAI 提出)指导下的大力出奇迹,对算力和数据有着近乎没有上限的需求。这直接孕育了海量的 GPU 需求,也带动了 HBM 的需求。

根据国外研究机构的拆解,英伟达力推的 H100 NVL 版本配备了 12 个 16GB HBM 堆栈,而单颗 16GB HBM 堆栈,成本就高达 240 美元。也就是说,仅仅 HBM 的成本就逼近 3000 美元,毫无疑问超过了制造和封装,是 H100 成本中最贵的一项。

即便如此,SK 海力士、美光 2024 年的 HBM 产能,也早被英伟达、AMD、英特尔、谷歌、微软等半导体厂商预订一空。

英伟达 H100 GPU,图/英伟达

高昂的定价和供不应求的订单,也让 HBM 厂商赚得盆满锅满。4 月 25 日刚公布的财报显示,SK 海力士今年第一季度营业利润为 2.8860 万亿韩元(约合人民币 151.8 亿元),不仅扭亏为盈,而且比起已经很乐观的市场预期:

还高出 30%。

要知道,这还是产能远远无法满足需求的情况。

而另一方面,大模型预训练最重要的一步就是语料库的采集。如果企业需要利用私有数据重新训练模型,同样也要经过数据收集、清洗等步骤。

不仅如此,涉及数据就不可避免要涉及「数据怎么存储、怎么管理、怎么保证数据安全,」联想凌拓首席执行官陆大昕在年初的一次演讲中表示,「这些都是后续大模型建设中的刚需。」

联想凌拓首席执行官陆大昕,图/联想

所以不难想象,伴随大模型进一步从数据中心扩散到更多、更分散的服务器,以及大模型应用的扩展和普及,需要更大的数据存储容量。这也就不奇怪,已经有大量厂商正在面向 AI 需求打造数据存储产品和解决方案。

国内知名存储厂商江波龙董事长蔡华波还在 2024 中国闪存市场峰会上表示:

江波龙要从存储模组厂向半导体品牌公司做转型,经营模式从原有的价差模式向服务模式转型。

AI 硬件元年,终端吞噬存储芯片

都说 2024 年是 AI 硬件元年,其实并不夸张。不只是很多人都听过的 AI 手机、AI PC,还有大量硬件产品,包括智能眼镜、电视乃至产品形态更新颖的 AI 原生终端,都在 2024 年集体亮相。

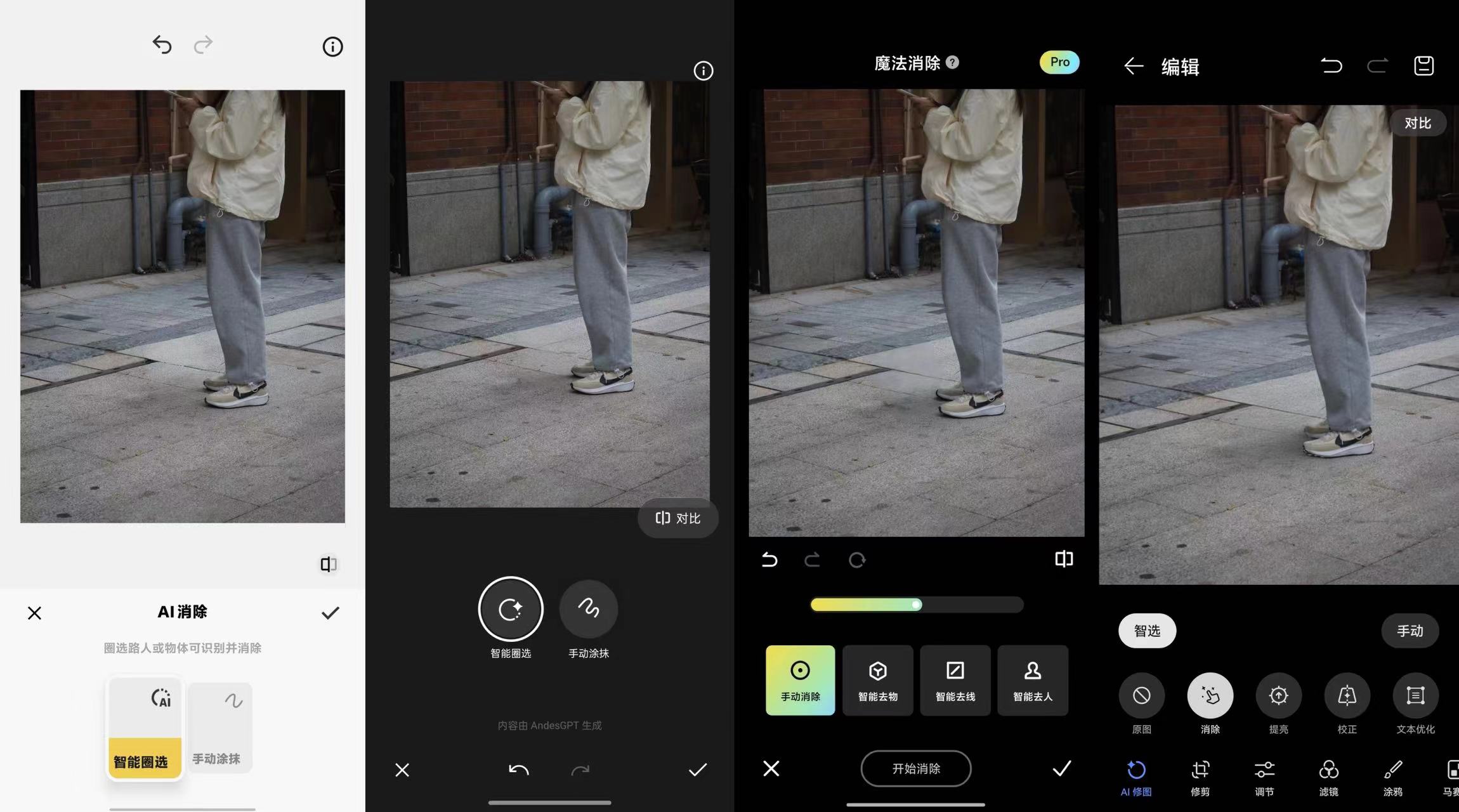

尽管很多产品在拥抱 AI 的过程中含有不少「水分」,比如可能只是接入了类 ChatGPT 的生成式 AI 聊天机器人,或者只是引入云端大模型的能力。但从「AI 消除」到「AI 通话/阅读摘要」,我们也要承认,基于背后的大模型,生成式 AI 的确开始改变我们的数字体验。

从左到右依次为 vivo、OPPO、小米、华为,图/雷科技

同时,不管是手机还是 PC 厂商都认同端侧大模型的势在必行,只有结合端侧和云端大模型,计算终端的体验才能发生革命性的演变。但与此相对的是,端侧算力和存储配置也变得前所未有地重要。

君不见,江波龙上个月就宣布将与西部数据「加强合作关系,积极探索并共同支持下一代基于人工智能的移动终端存储和应用的市场机遇。」更具体地说,江波龙要与西部数据联手面向手机市场提供「领先的定制化嵌入式存储解决方案」——也就是闪存,对应到手机上就是存储空间。

不仅如此,从财报公布的数据来看,截止 3 月 31 日,江波龙的存货账面金额猛然上升至 76 亿元,同比增长了 28%。按照江波龙的说法,存货增长主要是因为战略备货增加。但显然,更根本的原因是江波龙看好大模型在手机和 PC 等主要计算终端上的落地,必然需要更大的存储配置。

江波龙董事长蔡华波,图/中国闪存市场峰会

当然也不只是江波龙,前文提到的 SK 海力士以及三星都在向手机、PC 市场提供更大甚至更高带宽的内存,还计划参考 HBM,在 LPDDR 基础上引入新的堆叠和封装方式。

从数据中心到计算终端,这一轮席卷全球的 AI 浪潮不仅在助推存储芯片行业走出寒冬,也在将行业引向一个全新的周期。

写在最后

如果你相信大模型一定是未来,一定会走进千行百业,走进千家万户,那毫无疑问的是,存储芯片也一定是未来。

说到底,作为推动 AI 进化的三个核心要素之一,随着 AI 的逐步落地和普及,数据一定需要更大、更快的内存和闪存,也需要更适合 AI 时代的存储解决方案。

这是挑战,也是机遇。

尽管 SK 海力士、三星、美光三大存储芯片巨头在技术、资本、人才上的优势不言而喻,也几乎垄断了 HBM 供应。但对于包括江波龙在内的国产存储厂商来说,面向 AI 需求的储存解决方案依然是一个全新的领域,不管在个人移动终端上,还是在企业级市场上。

同时,这里也孕育了全新的可能。

来源:雷科技

原文标题 : AI浪潮下,存储芯片高歌猛进

图片新闻

最新活动更多

-

7月30-31日报名参会>>> 全数会2025中国激光产业高质量发展峰会

-

7.30-8.1马上报名>>> 【展会】全数会 2025先进激光及工业光电展

-

免费参会立即报名>> 7月30日- 8月1日 2025全数会工业芯片与传感仪表展

-

精彩回顾立即查看>> 维度光电·引领光束质量分析应用全新浪潮【免费下载白皮书】

-

精彩回顾立即查看>> 2024(第五届)全球数字经济产业大会暨展览会

-

精彩回顾立即查看>> 【线下会议】全数会2024电子元器件展览会

推荐专题

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论